Der Informationsraum

#006 Media Literacy neu gedacht; Brussels Effect und Desinfo; Meme Warfare; RUS TrashTV; Community Notes auf X

Willkommen zurück im Informationsraum – dem zweiwöchentlichen Briefing zu Desinformation, kognitiver Kriegsführung und strategischer Einflussnahme im digitalen Zeitalter.

Für alle, die nicht nur Headlines lesen, sondern Mechanismen verstehen wollen. Die vierte Ausgabe führt weiter, was wir begonnen haben: Entwicklungen sichtbar zu machen, die unterhalb der Schwelle klassischer Sicherheitsbedrohungen operieren – aber gesellschaftlich tief wirken.

Worum es diese Ausgabe geht:

In dieser Ausgabe unseres 14-tägigen Newsletters hat sich Tim mit der Frage beschäftigt, warum Xs Community Notes als Mittel gegen Desinformation versagen – besonders im globalen Süden, wo sprachliche Ungleichheit zur systemischen Schwäche wird. Im Anschluss analysiert er Frankreichs neuen OSINT-Ansatz, der mit dem B2RS-Bataillon zivile Expertise in die militärische Aufklärung integriert und digitale Resilienz durch strukturierten Kapazitätsaufbau stärkt. Markus widmet sich der politischen Funktion von Memes im Kontext hybrider Konflikte und zeigt am Beispiel von NAFO, wie digitale Gegenöffentlichkeit zur verteidigenden Informationsstrategie werden kann. Und Anamaria beleuchtet, wie russisches Reality-TV als subtiler Träger autoritärer Kriegs- und Familiennarrative fungiert – eine neue Form staatlich orchestrierter Soft Power im Gewand der Unterhaltung.

Media Literacy neu gedacht? - Herausforderungen, Modelle und Handlungsperspektiven für Deutschland

Vom Machtfaktor zur Zielscheibe – Der Wandel des „Brussels Effect“

Teenie Mütter goes Propaganda - Russische Reality-TV-Formate als Propagandawerkzeug

Gefährliche Lücken bei X - Warum Community Notes Desinformation nicht stoppen

Medien- und Informationskompetenz im Zeitalter digitaler Desinformation: Herausforderungen, Modelle und Handlungsperspektiven für Deutschland

Von Markus

Abstract: Der Bericht des Weltwirtschaftsforums „Rethinking Media Literacy: A New Ecosystem Model for Information Integrity“ thematisiert die zunehmende Bedrohung der Informationsintegrität im digitalen Zeitalter durch Desinformation, insbesondere vor dem Hintergrund der Verbreitung generativer Künstlicher Intelligenz (GenAI). Der Text plädiert für eine umfassende, systemische Neuausrichtung von Media and Information Literacy (MIL), um eine resiliente, demokratische und informierte Gesellschaft zu fördern.

An dieser Stelle zunächst ein ungewohnt persönlicher Exkurs: In einer früheren Nebentätigkeit als Nachhilfelehrer sah ich mich einmal mit der ernsthaften Aussage eines Oberstufenschülers konfrontiert, die Presse stünde unter der Kontrolle der Bundesregierung. Man kann sich meine schockierte Reaktion vorstellen. Ein anderer übernahm unreflektiert Trump-Wahlkampfslogans von TikTok und beharrte darauf, „Sleepy Joe“ hätte die US-amerikanische Wirtschaft ruiniert.

Von der Dringlichkeit medialer Bildung im Zeitalter von TikTok und GenAI

In nahezu jeder bildungspolitischen Debatte wird die Notwendigkeit von Medienkompetenz thematisiert, die es den SchülerInnen zu vermitteln gilt. Zu volle Stundenpläne und LehrerInnenmangel sorgen aber dafür, dass diesem Problem im besten Fall nur verzagt in Form von Workshops oder Projekttagen begegnet wird.

Gerade die Nutzung der vielfältigen Social Media-Plattformen durch Jugendliche macht eine Auseinandersetzung mit diesem Thema unabdingbar. Laut einer Studie des Digitalverbands Bitkom nutzen rund 93 % der Kinder und Jugendlichen im Alter von 10 bis 18 Jahren soziale Netzwerke. YouTube ist bei 87 % der 10‑ bis 18‑Jährigen die meistgenutzte Plattform, Instagram und Snapchat folgen je mit rund 53 %, TikTok wird von 51 % genutzt. Bei den 16‑ bis 18‑Jährigen steigt die Instagram‑Nutzung auf 85 %, bei den 14‑ bis 15‑Jährigen ist TikTok mit 73 % besonders stark vertreten. Die durchschnittliche tägliche Nutzungsdauer liegt bei 95 Minuten, bei älteren Jugendlichen (16–18 Jahre) sogar bei rund 134 Minuten – also über zwei Stunden täglich.

Und wer selbst auf diesen Plattformen unterwegs ist, weiß, wie sich auf diesen auch Desinformationen verbreiten, die sich den Eigenschaften sozialer Netzwerke bedienen. Sie zirkulieren auf Social Media durch eine Kombination aus algorithmischer Verstärkung, emotionalisierender Ansprache und gezielter Manipulation durch Akteure mit politischem oder wirtschaftlichem Interesse. Bereits ein erheblicher Teil der erwachsenen NutzerInnen ist nicht in der Lage, Desinformation zu erkennen oder Quellen korrekt einzuordnen, was ihre Verbreitung zusätzlich erleichtert (vgl. Guess et al., 2019). Welche Schwierigkeiten treten diesbezüglich erst bei jugendlichen ReziepentInnen auf? Und diese verstärken sich aktuell durch den Einsatz generativer Künstlicher Intelligenz (GenAI).

Entsprechend veröffentlichte das Weltwirtschaftsforum kürzlich den Bericht „Rethinking Media Literacy: A New Ecosystem Model for Information Integrity“, welcher die zunehmende Bedrohung der Informationsintegrität im digitalen Zeitalter thematisiert und besonders auf die Verbreitung von GenAI blickt. Der Text plädiert für eine umfassende, systemische Neuausrichtung von Media and Information Literacy (MIL), um eine resiliente, demokratische und informierte Gesellschaft zu fördern. Der Begriff selbst vereint Kompetenzen aus verschiedenen Bereichen, darunter Medienkompetenz, Informationskompetenz, digitale Kompetenz und zunehmend auch KI-Kompetenz. MIL wird in der UNESCO-Definition als „eine Kombination von Kompetenzen, welche die Menschen in die Lage versetzen, Informationen kritisch zu bewerten, zu nutzen und zu erstellen, sowie sich ethisch und effektiv in verschiedenen Medienformaten zu bewegen“ verstanden (UNESCO, 2021).

Als Problemstellung wurde zunächst die Schwächung des öffentlichen Vertrauens in Medien, Institutionen und Plattformen durch die rasante technologische Entwicklung und die digitale Verbreitung von Informationen identifiziert. Auch im Global Risks Report 2025 wurde Desinformation als zentrales Risiko für gesellschaftliche Stabilität und Demokratie ausgemacht. Vor diesem Hintergrund zielt der Bericht darauf ab, MIL neu zu denken – nicht nur als individuelle Kompetenz, sondern als gesellschaftliche Infrastruktur.

Der Bericht selbst führt zwei miteinander verbundene Modelle ein:

Disinformation Life Cycle – beschreibt fünf Phasen der Desinformationsverbreitung: Pre-creation, Creation, Distribution, Consumption, Post-consumption.

Socio-Ecological Model (SEM) – zeigt fünf Ebenen gesellschaftlicher Einflussnahme: Individuum, interpersonelle Beziehungen, Gemeinschaft, Institutionen, Politik.

Durch die Kombination dieser Modelle wird ein interdisziplinärer, mehrdimensionaler Ansatz zur Intervention ermöglicht.

Lage in Deutschland

Deutschland steht – wie viele andere demokratische Staaten – vor der Herausforderung, die Integrität seiner Informationsräume zu schützen. Bereits die Bundestagswahl 2021 zeigte das Risiko durch gezielte Desinformationskampagnen, insbesondere über soziale Medien. Trotz eines ausgeprägten Mediensystems, einer aktiven Zivilgesellschaft und bewährter öffentlich-rechtlicher Rundfunkanstalten sind auch in Deutschland Vertrauen in Medien, politische Institutionen und Plattformen rückläufig – ein Nährboden für Desinformation.

Zwar existieren etablierte Strukturen der politischen Bildung (z. B. Bundeszentrale für politische Bildung), doch es fehlt bislang an einem kohärenten, national koordinierten Medienbildungsrahmen, der sowohl formale als auch non-formale Bildungssektoren integriert.

Das Modell des Disinformation Life Cycle bietet einen sinnvollen Rahmen für deutsche Akteure, um Desinformation nicht nur reaktiv zu begegnen, sondern proaktiv zu unterbrechen. Deutschland hat mit dem Netzwerkdurchsetzungsgesetz (NetzDG) und der Beteiligung an der EU-weiten Umsetzung des Digital Services Act (DSA) regulatorische Grundlagen gelegt, die sich gut in die vom Bericht vorgeschlagenen Phasen Creation, Distribution und Post-consumption einordnen lassen.

Allerdings fehlt eine starke Verankerung auf der Pre-creation-Ebene, etwa durch strukturelle Prävention über Bildung, Framing-Kompetenz und narrative Resilienz.

Das SEM ist besonders relevant für ein föderales Bildungssystem wie in Deutschland. Es bietet eine systematische Möglichkeit, die Vielzahl beteiligter Akteure – von Schulen, Landesmedienanstalten, Eltern, Vereinen, Medienhäusern bis hin zur Bundespolitik – in eine gemeinsame Strategie zu integrieren. Der Bericht betont explizit die Notwendigkeit lokaler, kulturell eingebetteter Interventionen – was in Deutschland mit seinem dezentralen Mediensystem hohe Anschlussfähigkeit besitzt, aber zugleich Koordinationsprobleme offenbart.

Der Forschungsbericht identifiziert MIL als wesentliches Instrument zur Stärkung der Informationsintegrität und Demokratiefähigkeit. Er hebt hervor, dass MIL Kompetenzen wie Informationsbewertung, Analysefähigkeiten zu KI-generierten Inhalten oder Verständnis für die Algorithmen und ökonomischen Mechanismen von Social Media-Plattformen umfasst. Dabei wird betont, dass MIL nicht nur im schulischen Kontext, sondern auch in der Erwachsenenbildung, im Berufsleben, in der Gemeindearbeit und durch zivilgesellschaftliche Akteure gefördert werden muss. Ebenso wichtig ist die Rolle von Plattformen und Regulierungsbehörden, die durch gezielte Eingriffe systemische Anreize für die Verbreitung glaubwürdiger Informationen setzen sollten.

Die Bundesrepublik verfügt dabei über mehrere vielversprechende Ansätze, auf denen aufgebaut werden kann:

· Initiativen wie „journalismus macht schule“, „Klicksafe“ oder „Medienkompetenzrahmen NRW“ zeigen, dass MIL bereits in Schulen und Fortbildungen integriert wird – allerdings oft projektbasiert und ohne langfristige Verstetigung.

· Die Landesmedienanstalten fördern Projekte zur Aufklärung über Desinformation, jedoch variiert der Umfang zwischen Bundesländern stark.

· Digitale Zivilgesellschaft (z. B. Correctiv, Mimikama, FragDenStaat) spielt eine zentrale Rolle in der Aufklärungsarbeit, allerdings meist mit begrenzten Ressourcen und ohne gesetzliche Verankerung.

· Die Einbindung von Influencern und Content Creators in der politischen Kommunikation (z. B. durch die Bundesregierung während der Corona-Pandemie) kann als Best-Practice im Bereich „Community“ (SEM-Ebene) gewertet werden – muss jedoch professionalisiert werden, wie der Bericht vorschlägt.

Trotz dieser vorhandenen pluralistischen Strukturen und AkteurInnen benennt der Bericht auch kritische Defizite, wie am Beispiel Deutschlands etwa:

· Fragmentierung: Es fehlt an einer bundesweit abgestimmten MIL-Strategie. Bildung ist Ländersache; viele Programme sind nicht übertragbar oder werden nur lokal implementiert.

· Fehlende KI-/GenAI-Kompetenzen in der Bildung: Der Bericht fordert explizit, AI Literacy in MIL zu integrieren. In deutschen Schulen ist diese Kompetenz kaum vorhanden, obwohl LLMs und Deepfakes zunehmend genutzt werden.

· Ungleichgewicht zwischen Plattformregulierung und Nutzerbildung: Während regulatorische Maßnahmen (NetzDG, DSA) existieren, hinken Bildungsmaßnahmen hinterher – insbesondere außerhalb des Schulkontextes (z. B. bei älteren Zielgruppen).

· Ressourcenschwäche: Viele Initiativen sind fördermittelabhängig und projektbasiert – ohne nachhaltige Finanzierungsmechanismen oder Monitoring-Standards.

Zuletzt liefert der Bericht auch einige Handlungsempfehlungen für Deutschland, die sich wie folgt zusammenfassen lassen:

· Bundesweite Koordinierung einer MIL-Strategie unter Federführung z. B. des Bundesministeriums für Forschung, Technologie und Raumfahrt (BMFTR) gemeinsam mit den Ländern.

· Verankerung von MIL als Pflichtkompetenz in den schulischen Bildungsplänen – mit Fokus auf KI-Kompetenz, Desinformationsanalyse, Fact-Checking und ethischer Mediennutzung.

· Ausweitung auf Erwachsenenbildung und berufliche Weiterbildung, insbesondere für öffentliche Bedienstete, Journalisten, Pädagogen und Pflegepersonal – Ziel: MIL als demokratische Basiskompetenz.

· Einbindung von Plattformen in Kooperationsverpflichtungen: Orientierung am UK-Ansatz (Ofcom, Safety-by-Design) könnte durch die Bundesnetzagentur oder Landesmedienanstalten adaptiert werden.

· Förderung lokaler MIL-Infrastrukturen: Bibliotheken, Volkshochschulen und Stadtverwaltungen als „MIL Hubs“ (ähnlich den UNESCO-„MIL Cities“) etablieren.

Letztlich bietet der Bericht des Weltwirtschaftsforums der Bundesrepublik eine strategische Grundlage, um Medienkompetenz von einer pädagogischen Randaufgabe zu einem strukturellen Pfeiler demokratischer Resilienz zu entwickeln. Die vorgeschlagenen Modelle eignen sich besonders gut für föderale und vielschichtige Gesellschaften wie Deutschland. Damit MIL jedoch wirksam wird, braucht es eine koordinierte nationale Strategie, finanzielle Nachhaltigkeit und die Integration von Plattformverantwortung, Bildung und gesellschaftlicher Teilhabe in eine gemeinsame Vision für ein gesundes Informationsökosystem.

Vom Machtfaktor zur Zielscheibe – Der Wandel des „Brussels Effect“

Von Tim

Abstract: In seinem neuen Artikel auf the Loop beleuchtet Mateusz Łabuz, IFSH, eine bemerkenswerte Umkehrung eines altbekannten Mechanismus der EU: des sogenannten Brussels Effect. Dieser beschreibt ursprünglich die normative und regulatorische Strahlkraft der Europäischen Union, deren Standards weit über die eigenen Grenzen hinaus wirksam werden – sei es durch die schiere Marktgröße oder durch ein Bekenntnis zu liberalen Werten wie Datenschutz, Transparenz und Menschenrechten.

Łabuz argumentiert jedoch, dass diese regulatorische Außenwirkung zunehmend ins Gegenteil verkehrt wird. Die EU sieht sich nicht mehr nur als globaler Normgeber, sondern wird selbst zum Ziel von Kampagnen, die ihre regulatorischen Ambitionen als innovationsfeindlich, übergriffig oder gar gefährlich für unternehmerische Freiheit darstellen. Dieser, wie er ihn nennt, Reverse Brussels Effect sei nicht bloß ein diskursives Phänomen, sondern ein Angriff auf das normative Fundament der EU selbst.

Der klassische „Brussels Effect“: Regulierung als Machtinstrument

Łabuz greift die von Anu Bradford etablierte Theorie des Brussels Effect auf, wonach die EU über die Kombination aus wirtschaftlicher Marktmacht und hoher regulatorischer Standards Einfluss auf globale Märkte nimmt. Unternehmen orientieren sich, oft aus reinem Effizienzdenken, lieber an den strikten EU-Vorgaben, statt verschiedene nationale Standards parallel zu bedienen. Der Brussels Effect zeigt sich exemplarisch an der DSGVO, da viele internationale Unternehmen – selbst außerhalb der EU – ihre Datenschutzstandards an die europäischen Vorgaben anpassen, um weiterhin Zugang zum EU-Binnenmarkt zu behalten.

Doch die Bedeutung dieses Effekts geht über wirtschaftliche Vorteile hinaus: Die EU kann durch ihre Regulierung auch Werte exportieren – etwa in den Bereichen Umwelt, Datenschutz oder digitale Grundrechte. Es handelt sich also um eine Form „weicher Macht“ (soft power), die bislang als Erfolgsmodell galt.

Der „Reverse Brussels Effect“: Regulierung als Angriffspunkt

Mit dem Begriff Reverse Brussels Effect beschreibt Łabuz die zunehmende Instrumentalisierung von Kritik an EU-Regulierungen, um die Legitimität und Autorität der EU zu unterminieren. Diese Kritik sei nicht immer sachlich oder wohlmeinend. Vielmehr würden Akteure wie Big-Tech-Konzerne oder auch politische Gegner der EU gezielt Narrative verbreiten, die ihre Regulierungsanstrengungen als innovationshemmend oder bürokratisch darstellen.

Ein prominentes Beispiel ist der EU AI Act von 2024 – eine ambitionierte Regulierung, die künstliche Intelligenz auf Basis ethischer Leitlinien bändigen will. Łabuz zeigt, wie diese Initiative, statt als Schutz demokratischer Werte verstanden zu werden, in einem zunehmend transatlantischen Diskurs als Zeichen europäischer Innovationsfeindlichkeit interpretiert wurde. Der Slogan „The US innovates, China replicates, and the EU regulates“ ist dabei Ausdruck eines unternehmerischen wie politischen Anti-EU-Narrativs, das sich vor allem in digitalen Öffentlichkeiten verfestigt. Obwohl konstruktive Kritik an Regulierungen wichtig ist, beruhen viele Vorwürfe auf Vereinfachungen oder sogar falschen Behauptungen. Diese gezielte Instrumentalisierung von Narrativen findet besonders bei europäischen Start-ups Anklang und wird in den sozialen Medien stark verstärkt. Sie wirkt wie eine selffulfilling prophecy – und schwächt letztlich die Innovationsfähigkeit der EU.

Kritik mit System: Die Narrative hinter dem Anti-Regulierungsdiskurs

Łabuz warnt, dass die Rhetorik gegen „Überregulierung“ oft auf Vereinfachungen oder gar Desinformation beruht – etwa der Vorwurf, Regulierung bremse per se technologische Entwicklung, oder sie sei inkompatibel mit unternehmerischer Freiheit. Dabei blendet die Kritik systematisch aus, dass gerade nicht- oder nur teilweise regulierte Technologien – wie KI oder Social Media – zunehmend zur Bedrohung demokratischer Prozesse werden können.

Besonders kritisch sieht Łabuz die Rolle US-amerikanischer Akteure, die in einem Klima strategischer Konkurrenz regulatorische Ambitionen der EU als geopolitisches Problem stilisieren – etwa in Aussagen wie jenen von US-Vizepräsident JD Vance, die die EU direkt als Bedrohung amerikanischer Werte darstellten. Dahinter erkennt Łabuz nicht bloß ökonomisches Kalkül, sondern einen bewussten Angriff auf die normative Autorität Europas.

Gefährdung der Werteexportfunktion – und was dagegen zu tun ist

Łabuz argumentiert, dass diese Form der Diskreditierung weitreichende Folgen hat: Sie schwächt nicht nur die regulatorische Position der EU nach außen, sondern auch ihre Fähigkeit zur Selbstbehauptung im Inneren. Wenn europäische Standards als Belastung und nicht als Errungenschaft wahrgenommen werden, wird der politische Rückhalt für regulatorische Vorhaben brüchig.

Er verweist auf den Umgang mit der DSGVO als Lehrstück. Auch sie wurde anfangs als überzogen kritisiert, gilt inzwischen aber weltweit als Vorbild für Datenschutzregelungen. Hier zeigt sich: Nachhaltige Regulierung braucht nicht nur Expertise, sondern auch Kommunikation, Resilienz und politisches Durchhaltevermögen. Łabuz fordert daher kein Weniger an Regulierung, sondern ein intelligenteres Regulieren – flankiert durch bessere Kommunikation, gezielte Förderung der Digitalwirtschaft und entschiedene Gegenwehr gegen anti-europäische Narrative. Der Rückzug aus der Rolle des globalen Normgebers wäre nicht nur ein strategischer Fehler, sondern eine Kapitulation vor jenen, die liberale Werte bewusst untergraben wollen.

Bewertung und Einordnung

Mateusz Łabuz gelingt mit dem Konzept des Reverse Brussels Effect ein scharfsinniger und empirisch anschlussfähiger Beitrag zur Debatte über die Rolle der EU in der digitalen Weltordnung. Besonders wertvoll ist seine Verbindung von normativer Analyse und diskurstheoretischer Beobachtung: Regulierung ist eben nicht nur ein technisches oder wirtschaftliches Thema, sondern ein zutiefst politischer Akt, der Angriffen ausgesetzt ist.

Gleichzeitig wirft der Artikel Fragen auf, die in zukünftigen Analysen vertieft werden sollten: Inwiefern trägt die EU selbst durch mangelnde Innovationsförderung oder komplizierte Verfahren zu ihrem Image als „Bürokratiemonster“ bei? Wie kann regulatorische Kommunikation verbessert werden, um auch Start-ups oder Tech-Szene für Werte-basierte Standards zu gewinnen? Und: Welche Rolle spielen interne politische Spannungen innerhalb der EU (z. B. zwischen Mitgliedstaaten) bei der Verwundbarkeit durch den Reverse Brussels Effect?

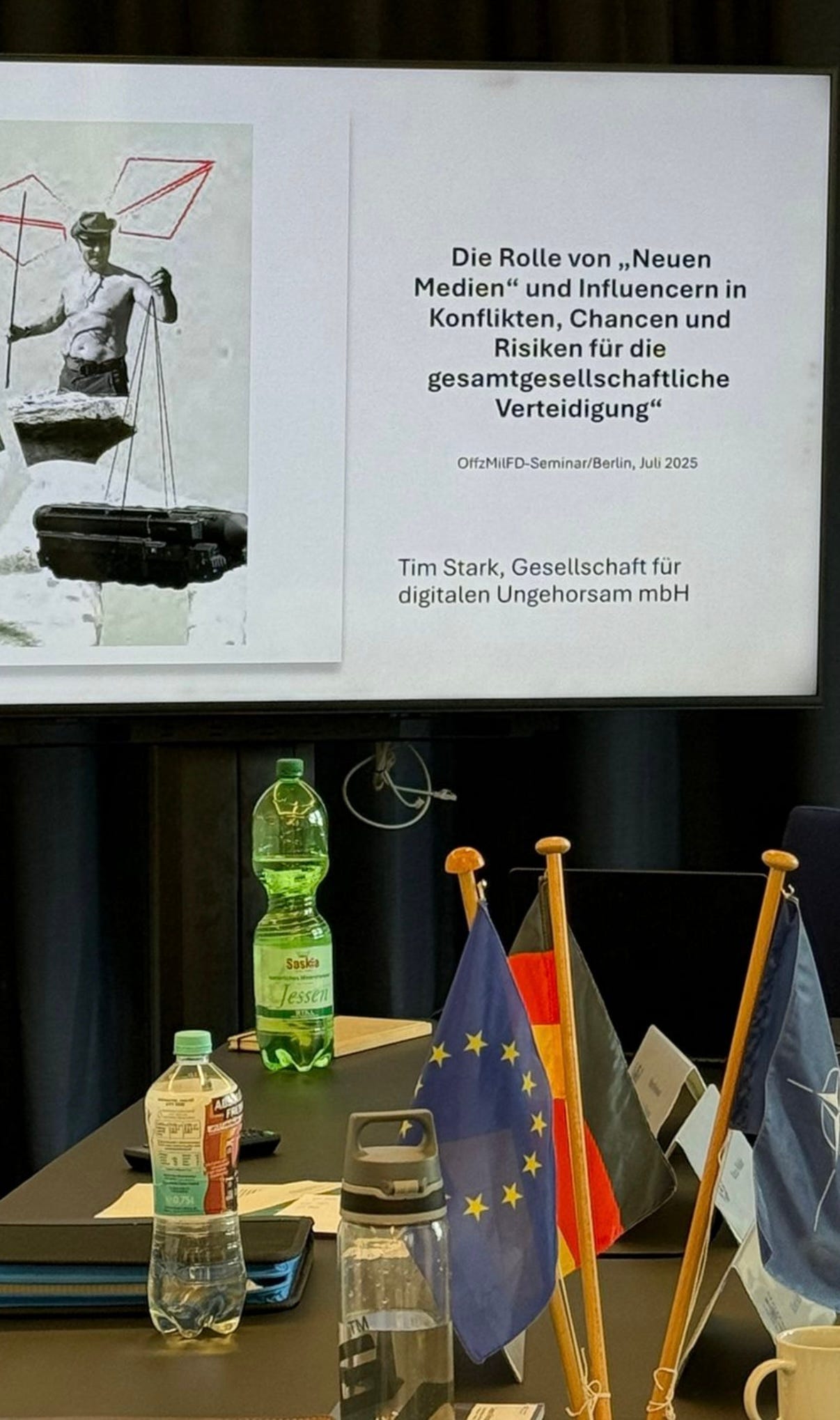

HAUSMITTEILUNG

Zum zweiten Mal hatte unser Kollege Tim die Gelegenheit, am Zentrum für Innere Führung der Bundeswehr einen Vortrag zum Thema „Die Rolle von Neuen Medien und Influencern in Konflikten – Chancen und Risiken für die gesamtgesellschaftliche Verteidigung“ zu halten. Anhand von Fallstudien aus der Ukraine, Deutschland, Israel, dem Iran, Myanmar und Litauen beleuchtet der Vortrag insbesondere die Wirkmechanismen digitaler Einflussnahme und Formen kognitiver Kriegsführung im Kontext gesamtgesellschaftlicher Resilienz.

Wenn auch Sie oder Ihre Organisation Interesse an einem Workshop, Vortrag oder Beratung zu hybriden Bedrohungen, Desinformation oder Einflusskampagnen haben, freuen wir uns über Ihre Nachricht an sekretariat@digitalerungehorsam.de .

eigenes Bild

„Memetic Warfare“ und digitale Gegenöffentlichkeit: Zur politischen Funktion von Internet-Memes im Kontext hybrider Konflikte und zivilgesellschaftlicher Selbstermächtigung

Von Markus

Abstract: Der Forschungsbericht The Complex Web in Memetic Warfare (Munk et al., 2025) untersucht die strategische Rolle von Internet-Memes im Kontext hybrider Konflikte am Beispiel der North Atlantic Fella Organization (NAFO). Im Fokus steht deren Nutzung memetischer Inhalte als Mittel zivilgesellschaftlicher Selbstermächtigung, Mobilisierung und digitaler Gegenöffentlichkeit im Rahmen des russischen Angriffskriegs gegen die Ukraine. Die interdisziplinäre Studie basiert auf einem Mixed-Methods-Ansatz (Umfrage, Interviews, visuelle Analyse) und entwickelt das Konzept der defensiven memetischen Kriegsführung. Sie zeigt, wie Memes nicht nur zur Verbreitung von Desinformation, sondern auch zur Stärkung demokratischer Narrative beitragen können. Der Bericht liefert praxisnahe Erkenntnisse für politische Bildung, Cyberabwehr und Medienregulierung.

Melodie, Modetrend, satirische Bild-Text-Kombination. So ließe sich der Lebenslauf eines sog. „Memes“ kurz zusammenfassen. Ursprünglich entstammt der Begriff tatsächlich aus dem Buch „The Selfish Gene“, welches der britische Evolutionsbiologe Richard Dawkins 1976 veröffentlichte. Dort definiert er das Meme als eine Einheit kultureller Replikation – also eine Idee, ein Verhalten oder ein Stil, der sich von Person zu Person durch Imitation verbreitet, analog zum Gen in der biologischen Evolution. Memes, so Dawkins, konkurrieren um Aufmerksamkeits- und Speicherkapazitäten in menschlichen Gehirnen – ganz ähnlich, wie Gene um biologische Ressourcen konkurrieren. Die erfolgreichsten verbreiten sich rasch und nachhaltig, die weniger erfolgreichen verschwinden.

Mit dem Aufkommen des Internets (vor allem ab den 1990er- und 2000er-Jahren) wurde der Begriff „Meme“ in veränderter Bedeutung populär:Er bezeichnete nun digitale Bild-Text-Kompositionen, die sich humorvoll, satirisch oder kritisch mit Ereignissen, Personen oder Kulturen auseinandersetzen – meist durch virale Verbreitung über soziale Medien (Facebook, Reddit, X/Twitter, etc.).

Die Forschung spricht hierbei auch von:

„Internet-Memes“ (Shifman, 2014)

„memetic culture“ oder

„remix culture“ (Jenkins, 2006)

Internet-Memes haben sich dabei von simplen Witzbildern zu hochdynamischen Formen politischer Kommunikation, Protestkultur und kollektiver Affektartikulation entwickelt.

In der letzten Ausgabe unseres Newsletters haben wir bereits kurz das „Meme-Potenzial“ diverser russischer hybrider Aktionen betrachtet (Bundeskanzler Merz, der Robben und Eisbären erschießt). Die Bedeutung und letztlich auch die Gefahr, die von meme-gestützten Desinformationskampagnen ausgeht, darf nicht ausgeblendet oder unterschätzt werden. Memes spielen also eine zentrale Rolle bei der Verbreitung von Desinformationen, da sie durch ihre visuelle, pointierte und oft humorvolle Form besonders geeignet sind, komplexe oder manipulative Inhalte schnell und wirksam zu transportieren. Ihre kulturelle Anschlussfähigkeit und virale Struktur machen sie zu einem wirkungsvollen Instrument in digitalen Desinformationskampagnen – sowohl auf individueller als auch auf staatlicher Ebene.

Von viraler Satire zur strategischen Kommunikation

In der wissenschaftlichen Auseinandersetzung mit digitalen Kulturen haben sich Memes als ein paradigmatisches Phänomen entpuppt, das zentrale Dynamiken der Netzwerkgesellschaft bündelt: visuelle Verdichtung, partizipative Aneignung und affektive Mobilisierung. Ursprünglich als humoristische Randerscheinungen betrachtet, sind Memes längst zu relevanten Trägern politischer Kommunikation avanciert. Sie fungieren als diskursive Knotenpunkte, über die gesellschaftliche Deutungsmuster zirkulieren, verhandelt und transformiert werden.

Die bisherige Forschung hat sich primär auf die instrumentalisierte Nutzung von Memes im Rahmen rechtspopulistischer Bewegungen, extremistischer Online-Öffentlichkeiten oder staatlich orchestrierter Desinformationskampagnen konzentriert. Deutlich weniger Aufmerksamkeit wurde bislang der Frage gewidmet, inwiefern Memes auch als Werkzeuge zivilgesellschaftlicher Selbstermächtigung und verteidigender Informationsintervention fungieren können.

Die Kriminologin Dr. Tine Munk, die an der Nottingham Trent University lehrt, hat aktuell mit drei KollegInnen den Forschungsbericht „The Complex Web in Memetic Warfare: A Comprehensive Analysis of Societal Dynamics, Interactions and Impact“ (BA / Leverhulme Small Research Grants Scheme 2024–25) veröffentlicht und analysiert darin die strategische Verwendung von Memes im Rahmen zivilgesellschaftlicher Widerstandsformen und hybrider Informationskriegsführung während des russischen Angriffskrieges gegen die Ukraine. Im Zentrum der Untersuchung steht die North Atlantic Fella Organization (NAFO) als exemplarischer Fall für digitale Graswurzelbewegungen, die Memes als Instrumente der Informationsresilienz, der Mobilisierung und der Gegennarrativbildung einsetzen.

Die Studie selbst ist interdisziplinär verankert in der Medien-, Kommunikations- und Sicherheitsforschung. Sie greift Konzepte wie „Information Disorder“ (vgl. Wardle & Derakhshan), hybride Einflussoperationen, Soft Power sowie zivile Widerstandsstrategien auf und entwickelt das Konzept der defensiven memetischen Kriegsführung als genuin digitale Form des Widerstands weiter.

Memes haben sich, laut Munk, als zentrale Ausdrucksform digitaler Medienkultur etabliert, deren Wirkmächtigkeit weit über bloße Unterhaltung hinausreicht. In ihrer Funktion als verdichtete, oft humoristisch codierte Träger sozialer Bedeutungen operieren sie im Spannungsfeld zwischen individueller Kreativität und kollektiver Diskursproduktion. Limor Shifman beschreibt Memes als „Partizipationseinheiten“, die nicht nur durch ihre virale Struktur, sondern insbesondere durch ihre Anschlussfähigkeit an kulturelle Kontexte und affektive Resonanzräume politisch wirksam werden können (Shifman 2014:7). Im Kontext konflikthafter Auseinandersetzungen gewinnen Memes zunehmend strategische Bedeutung: Sie sind nicht nur Mittel der öffentlichen Meinungsbildung, sondern auch Vehikel für Propaganda, Mobilisierung und Widerstand. Die Forschung spricht in diesem Zusammenhang von „memetischer Kriegsführung (memetic warfare)“ – einem Subtyp hybrider Konfliktführung, in dem digitale Inhalte gezielt zur Destabilisierung oder Stärkung von Narrativen eingesetzt werden (Milner 2013:2530ff). Während autoritäre Akteure Memes oftmals offensiv verwenden, um Desinformation zu verbreiten und demokratische Diskurse zu untergraben (vgl. Culloty & Suiter: 2021), gewinnt die Praxis der defensiven memetischen Kriegsführung zunehmend an Aufmerksamkeit: Hier werden Memes genutzt, um Desinformation zu entlarven, moralische Unterstützung zu signalisieren und kollektive Widerstandskraft zu stärken (Munk 2025: 3ff). Als empirische Beispiele seien hier genannt:

Während der US-Präsidentschaftswahl 2016 verbreiteten russische Trollfarmen memetische Inhalte zu Themen wie Black Lives Matter, Islam, Waffenrecht etc., um Spannungen zu schüren.

COVID-19-Verschwörungstheorien wurden erfolgreich über Meme-Formate wie „Distracted Boyfriend“ oder „Mocking SpongeBob“ verbreitet.

In der Ukraine-Desinformationskampagne nutzte Russland Meme-Formate zur Verhöhnung ukrainischer Politiker oder zur Verbreitung falscher Kriegsinformationen

Theoretisch lässt sich die politische Funktion von Memes über das Konzept der symbolischen Macht im Sinne Pierre Bourdieus fassen: Als kulturelle Artefakte, die in hochgradig visuell geprägten Medienökologien operieren, konkurrieren Memes um Aufmerksamkeit, Bedeutungshoheit und Legitimität (Bourdieu 1991: 170ff). Ihre Bedeutung entfaltet sich dabei nicht isoliert, sondern relational – durch Intertextualität, Community-Praxis und algorithmische Sichtbarkeit. In diesem Sinne fungieren Memes als taktische Interventionen in der digitalen attention economy, in der politische Wirksamkeit zunehmend von visueller Anschlussfähigkeit und viraler Reichweite abhängt (vgl. Citton 2014). Die hier analysierte memetische Praxis der NAFO lässt sich als exemplarischer Ausdruck einer solchen verteidigenden Medienpraxis lesen. NAFOs satirisch codierte Memes sind nicht nur Ausdruck einer kollektiven Gegenerzählung, sondern Teil eines breiteren Repertoires zivilgesellschaftlicher Selbstermächtigung, das zwischen digitalem Aktivismus, affektiver Mobilisierung und kultureller Selbstbehauptung oszilliert (vgl. Munk 2025). Damit verschiebt sich der Fokus von der Analyse manipulativer Informationsoperationen hin zur Erforschung widerständiger Medienpraktiken in digitalen Konflikträumen.

Reichweite, Radikalisierung und Resilienz

Munk’s Studie verfolgt drei Hauptziele:

Analyse von Wahrnehmung, Reichweite und Wirkung pro-ukrainischer memetischer Kriegsführung;

Untersuchung der Motivationen und Mechanismen hinter der Beteiligung zivilgesellschaftlicher Akteure an digitalem Widerstand;

Bewertung der tatsächlichen Effekte dieser digitalen Praktiken auf politisches Bewusstsein, öffentliche Meinungsbildung und gesellschaftliche Solidarität.

Methodisch stützt sich die Studie auf einen Mixed-Methods-Ansatz: Es wurden eine Online-Umfrage unter NAFO-Mitgliedern (n=255), qualitative Interviews mit 18 internationalen NAFO-AktivistInnen sowie 21 ukrainischen ZivilistInnen durchgeführt, ergänzt durch visuelle Inhaltsanalysen von Meme-Datensätzen. Als Praxisbeispiele fungieren bspw. die Verbreitung memetischer Inhalte

Unsere Learnings aus dem Bericht:

Memes kondensieren komplexe Inhalte in leicht konsumierbare visuelle Formate, die oft auf emotionalen Triggern wie Angst, Wut oder Spott basieren. Durch diese Affektbindung sinkt die kognitive Schwelle zur Aufnahme und Weiterverbreitung, was ihre Reichweite erhöht. Sie benötigen kein tiefes Vorwissen und sprechen auch politikferne oder bildungsferne Zielgruppen an. Gerade in fragmentierten digitalen Öffentlichkeiten wirken sie dadurch als ideale Vehikel zur Meinungsmobilisierung.

Desinformationen über Memes bedienen sich typischerweise folgender Strategien:

Satirische Verzerrung: Fakten werden in humoristische, aber irreführende Kontexte eingebettet, was ihre Falsifizierung erschwert.

Visuelle Manipulation: Bilder werden gefälscht, aus dem Kontext gerissen oder mit falschen Informationen versehen.

Ironie und Ambiguität: Durch Ironie wird Verantwortlichkeit verschleiert – Kritik kann so jederzeit als „nur Spaß“ relativiert werden.

In-Group-Codes: Memes nutzen Insider-Witze oder Sprachcodes (z. B. "clown world", "NPCs", "redpill"), um ideologische Positionen subtil zu transportieren.

Akteure wie Russland, China oder der Iran haben Memes gezielt in Informationsoperationen eingebunden, etwa über Trollfarmen oder koordinierte Netzwerke (z. B. Russlands „Internet Research Agency“). Ziel ist es, westliche Gesellschaften zu spalten, Misstrauen zu säen und gegnerische Narrative zu delegitimieren.

Rechtsextreme, verschwörungsideologische und antisemitische Gruppen nutzen Memes zur Radikalisierung, um ihre Ideologie in popkulturelle Form zu kleiden (z. B. Pepe the Frog, Wojak-Memes). Memes dienen hier der Normalisierung extremistischer Diskurse unter dem Deckmantel der Ironie.

Soziale Plattformen begünstigen visuell-emotionale Inhalte. Memes profitieren durch ihre Form vom algorithmischen Bias zugunsten hoher Engagement-Raten – sie werden häufiger geteilt, gelikt und empfohlen, unabhängig von ihrem Wahrheitsgehalt.

Wirkungsweisen und Risiken:

Verstärkung von Echokammern und Confirmation Bias → Memes reproduzieren und verfestigen bestehende Überzeugungen, statt zur kritischen Reflexion anzuregen.

Verlust von Kontext und Komplexität → Memes vereinfachen politische Prozesse auf einprägsame Schlagworte – dies fördert ein dichotomes Weltbild (gut/böse, wir/sie).

Schwierigkeit der Widerlegung → Aufgrund ihres ironischen Stils sind Meme-Inhalte schwer zu „debunken“ – klassische Fact-Checks wirken dagegen oft hilflos oder humorlos

Effektive Gegenstrategien:

Entwicklung von Memetracing-Technologien zur Analyse viraler Einflussnahme.

Förderung von faktengestützter, defensiver Memepraxis als Teil nationaler Cyberverteidigungsstrategien.

Integration von memetischer Kompetenzbildung in politische Bildung und Medienpädagogik.

Ausbau von plattformübergreifender Moderation und Inhaltskontrolle, u.a. durch KI-gestützte Detektion und Content-Labeling

Fazit:

Die Studie leistet einen substantiellen Beitrag zum Verständnis der Transformation politischer Kommunikation unter Bedingungen digitaler Medienökologie. In einer Zeit, in der Desinformationskampagnen globalen Einfluss auf demokratische Willensbildung nehmen, bietet der Bericht praxisrelevante Erkenntnisse für Politik, Zivilgesellschaft und Plattformregulierung. Die Autoren argumentieren überzeugend für die Notwendigkeit medienpädagogischer Interventionen, algorithmischer Transparenz und institutioneller Unterstützung von digitalen Gegenöffentlichkeiten.

Ein möglicher Kritikpunkt liegt in der begrenzten Repräsentativität der erhobenen Daten, insbesondere mit Blick auf das Geschlechterverhältnis der befragten NAFO-Mitglieder. Gleichwohl reflektiert das AutorInnenteam diesen Umstand transparent und plädiert selbst für eine Ausweitung zukünftiger Forschung.

Munk‘s Bericht ist ein innovativer, empirisch fundierter und theoretisch anspruchsvoller Beitrag zur Erforschung digitaler Widerstandsformen im 21. Jahrhundert. Er macht deutlich, dass Memes nicht als ephemere Internetkultur abgetan werden dürfen, sondern als ernstzunehmende Form politischer Artikulation und als Werkzeug im Kampf um Deutungsmacht verstanden werden müssen. Der Bericht ist damit nicht nur für die akademische Forschung von hoher Relevanz, sondern bietet auch konkrete Impulse für medienpolitische Strategien im Zeitalter hybrider Konflikte.

Russische Reality-TV-Formate als Propagandawerkzeug

Von Anamaria

Abstract: Der Artikel untersucht die zunehmende Instrumentalisierung von Reality-TV im Rahmen russischer Propaganda. Während traditionelle Nachrichtensendungen und Talkshows bereits seit Jahren eine offene Kriegsrhetorik vermitteln, werden in Formaten wie Dom-2, Davay Pozhenimsya oder Mama v 16 subtilere narrative Strategien sichtbar, die Krieg, patriarchale Familienmodelle und staatliche Ideologie normalisieren. Durch Emotionalisierung und Personalisierung wird eine Erzählung konstruiert, die den Angriffskrieg gegen die Ukraine als Fortsetzung historischer Verteidigungskämpfe mythologisiert, traditionelle Geschlechterrollen glorifiziert und frühe Mutterschaft als patriotische Pflicht inszeniert. Diese mediale Strategie fügt sich in ein umfassendes ideologisches Projekt ein, das neben der Medienlandschaft auch Bildungs- und Sozialpolitik umfasst, um patriarchale und nationalistische Werte hegemonial zu verankern. Reality-TV fungiert dabei nicht nur als Unterhaltungsformat, sondern als wirkmächtiges Instrument zur Emotionalisierung, Normalisierung und Legitimierung autoritärer Politik und gesellschaftlicher Kontrolle.

*In diesem Artikel werden pro-Kreml-Medien wie Lenta.ru zitiert. Diese Quellen sind nicht glaubwürdig und werden hier nur erwähnt, da sie oft die einzigen öffentlich zugänglichen Informationen über russische Reality-TV-Persönlichkeiten bereitstellen. Die Redaktion dieses Newsletters distanziert sich ausdrücklich von Tonfall und Inhalt der verlinkten Artikel.*

Dass zentrale russische Medienformate der politischen Propaganda dienen, ist nichts Neues. Namen wie Wladimir Solowjow oder Margarita Simonjan sind fest mit dem Staatsfernsehen und dem Versuch verbunden, ein geschlossenes ideologisches Weltbild zu vermitteln. Während klassische Nachrichtensendungen oder Talkshows bereits seit Jahren als offensichtliche Plattformen für kriegsbefürwortende Rhetorik fungieren, hat sich in den letzten Jahren ein neues Feld geöffnet: das Unterhaltungsfernsehen, genauer gesagt das Reality-TV. In subtileren, emotionalisierten Formaten wird hier eine Erzählung produziert, die Krieg verherrlicht, staatliche Entscheidungen legitimiert und insbesondere die Idee traditioneller Familienwerte als moralisches Rückgrat der Gesellschaft in den Mittelpunkt rückt.

Soft Power, Hard Messages: Propaganda durch Reality-TV

Ein Beispiel dafür ist das Show „Dom-2” („Haus-2”), eine der langlebigsten und populärsten Reality-TV-Shows in Russland. Seit 2004 läuft die Sendung mit dem einfachen Konzept, dass die TeilnehmerInnen gemeinsam in einem Haus wohnen und dabei nach einem Beziehungspartner oder einer Beziehungspartnerin suchen. Das Format selbst thematisiert den Krieg nicht offen. Dennoch ist es kein unpolitischer Raum. Ehemalige Teilnehmende, von denen viele eine anhaltende mediale Präsenz haben, positionieren sich öffentlich zum Krieg in der Ukraine im Sinne der staatlichen Linie. Alexander Zadoynov etwa, der seit 2007 wiederkehrend in der Sendung zu sehen war, verkündete im Dezember 2023 in seinen sozialen Netzwerken, dass er sich freiwillig zur Front begebe, um „den Weg der Großväter und Urgroßväter fortzusetzen“ und „gegen allerlei böse Geister zu kämpfen“. Diese Wortwahl ist kein Zufall, sondern reiht sich in eine nationalistische Kriegsnarration ein, die den Angriffskrieg als Fortsetzung eines historischen Verteidigungskampfes mythologisiert.

Während Zadoynov als Einzelperson agiert, gehen andere Formate deutlich weiter: Die Heirats-Show „Davay Pozhenimsya“ („Lass uns heiraten“) ist beispielsweise seit 2008 auf Sendung. Im Jahr 2023 kündigte die prominente Kupplerin der Show, Roza Syabitova, eine Spezialfolge mit Teilnehmenden der sogenannten „Spezialoperation“ an. Ziel sei es, so Syabitova, dem Publikum „positive Emotionen” zu vermitteln. In ihrer Sprache wurde deutlich, wie eng Emotionalisierung und Kriegsverklärung inzwischen verbunden sind. Man wolle eine „starke, coole, großartige Sendung“ machen, die nicht nur die ZuschauerInnen, sondern auch das Team selbst zu Tränen rühre. Zu erwünschen im Show seien mehr heldenhafte Kämpfer, die die Heimat verteidigen.

In einer Spezialfolge, die am 9. Mai 2024 zum Tag des Sieges ausgestrahlt wurde, stand der Freiwillige Danil Malinsky im Mittelpunkt. Er wurde als freundlicher und hilfsbereiter Bürger dargestellt, der sich der Front angeschlossen hat, um russische Spezialeinheiten mit humanitärer Hilfe zu versorgen. Seine Organisation trägt den Namen „Volks-Erste-Hilfe-Kasten“ - ein bewusst harmlos klingender Titel, der das Engagement als uneigennützige Zivilinitiative erscheinen lassen soll. Tatsächlich wurde Malinsky öffentlich von Wladislaw Dawankow, dem stellvertretenden Vorsitzenden der Staatsduma, gelobt, was nahelegt, dass seine Inszenierung in der Show keineswegs zufällig war. Im Finale der Folge bereitet die Auserwählte des Freiwilligen symbolträchtige „Kriegsgerichte” zu, die gemeinsam gegessen werden - ein inszenierter Akt häuslicher Normalität im Schatten eines brutalen Angriffskrieges.

Diese Formate funktionieren über das Persönliche. Die ZuschauerInnen begegnen hier vermeintlich gewöhnlichen Menschen, die entweder an der Front kämpfen oder sich, wie im Fall Malinsky, der militärischen Unterstützung verschreiben. Die Dramaturgie emotionalisiert und bändigt Pathos und Patriotismus in Ehewünsche, romantische Gesten und familiäre Szenarien. Das politische Ziel liegt jedoch offen zutage: Der Krieg wird normalisiert und die Familie als Gegenmodell zum Westen ideologisiert.

Diese Tendenz steht jedoch nicht für sich allein. Sie ist Teil einer breiteren Strategie der russischen Regierung, mit Hilfe verschiedener gesellschaftlicher Sektoren: Medien, Bildung und Sozialpolitik ein ideologisches Klima zu schaffen, das nationale Stärke, weibliche Gebärfähigkeit und patriarchale Strukturen in den Mittelpunkt rückt. Besonders deutlich wird das im Kontext des demografischen Problems. Seit Beginn des Angriffskriegs gegen die Ukraine ist die russische Bevölkerung deutlich geschrumpft, durch Abwanderung junger Männer, einen rapiden Anstieg der Sterberaten und einen Rückgang der Geburten.

„Mama v 16” und Familienbild

Quelle: Mama v 16, YouTube

Die Regierung setzt auf Moralappelle, wirtschaftliche Anreize für frühe Mutterschaft sowie mediale Kampagnen gegen kinderfreie Lebensentwürfe. So wurde in mehreren Regionen ein neues Schulfach mit dem Titel „Grundlagen der Familienkultur“ eingeführt, das Ehe, Mutterschaft, Reproduktion und Rollenverteilung behandelt, allerdings strikt entlang heteronormativer Linien. Sexualaufklärung, Verhütung oder alternative Familienmodelle werden nicht thematisiert. Im Zentrum steht die Vorstellung, dass eine Frau in erster Linie Mutter und Ehefrau zu sein habe und der Mann als Versorger und Verteidiger fungiere.

Diese Botschaften setzen sich auch im Reality-TV fort. Ein weiteres Beispiel für das Ineinandergreifen von Unterhaltung, Moralismus und staatlich gewünschtem Verhalten ist die Sendung „Mama v 16“ („Mutter mit 16”; früher: „Schwanger mit 16“). Das Format zeigt minderjährige Mütter, oft mit schwierigen familiären Hintergründen, die sich durch das Leben kämpfen, jedoch stets mit dem Subtext, dass frühe Mutterschaft erstrebenswert sei. Seit 2023 wird die Sendung gezielt umgestaltet. Anstatt die Herausforderungen zu beleuchten, wird Mutterschaft nun als heroischer Akt inszeniert, um junge Zuschauerinnen zur frühen Familiengründung zu „motivieren“. Mediale Repräsentationen wie diese werden von einem staatlichen Diskurs gestützt, in dem Mutterschaft als patriotische Pflicht dargestellt wird.

Gleichzeitig wird ein kinderfreies Leben zunehmend delegitimiert. So wurde Ende 2024 ein Gesetzesentwurf zur Bestrafung sogenannter „Childfree-Propaganda“ eingebracht, der empfindliche Geldstrafen vorsieht. Der Begriff selbst bleibt diffus und kann faktisch alles umfassen. In mehreren Regionen wurden zudem Maßnahmen eingeführt, die Abtreibungen erschweren, etwa durch verpflichtende psychologische Beratungen oder lange Wartezeiten. In Kombination mit finanziellen Anreizen, wie etwa Einmalzahlungen von umgerechnet 1.000 Euro für schwangere Minderjährige, ergibt sich ein klar erkennbares Ziel: Frauen sollen früh, häufig und möglichst ohne Widerspruch Kinder bekommen.

Der Marburger Medienwissenschaftler Prof. Dr. Andreas Dörner hat herausgearbeitet, wie politische Inhalte auch in Unterhaltungsformaten, wie Kinofilmen oder TV-Serien, transportiert werden und hat entsprechend den Begriff des “Politainment” geprägt. Diesbezüglich postuliert er: “Der erzählende bzw. dramatische Modus der Konstruktion von Wirklichkeit, der auf der Grundlage einer narrativen Spielhandlung eine Als-ob-Welt gestaltet, wird schon lange Zeit als Möglichkeit politischer Erfahrung gepflegt” (Dörner, 2000:162).

Die Bedeutung audiovisueller Informationsvermittlung durch politische AkteurInnen beschreibt auch Linda Hentschel folgendermaßen: “Von Bildern als Regierungstechnologien zu sprechen, heißt zu fragen, wie Dinge repräsentiert werden, damit sie einem Bewältigungs- und Sicherheitsphantasma dienen können” (Hentschel, 2008:13).

Die dargestellten Reality-TV-Formate sind aber nicht nur eine Ablenkung vom Alltag, sondern tief verankerte Instrumente eines umfassenden ideologischen Projekts. Sie emotionalisieren, verharmlosen und normalisieren eine politische Agenda, die Gewalt, Patriarchat und Kontrolle über individuelle Lebensentwürfe zum Ziel hat. So wird Krieg zur Kulisse für romantische Begegnungen, junge Mütter zur patriotischen Idealfigur stilisiert und weibliche Selbstbestimmung durch narrative Wiederholung schrittweise ausgehöhlt.

Gefährliche Lücken: Warum Community Notes Desinformation nicht stoppen

Von Tim

Abstract: Seit seiner Einführung als „Community Notes“ (ehemals „Birdwatch“) hat X – früher bekannt als Twitter – ein ambitioniertes Ziel verfolgt: Desinformation durch die kollektive Intelligenz der Nutzer einzudämmen. Statt zentraler Moderation setzt das System auf „kontextualisierende“ Kommentare, die Nutzende in einem strukturierten Verfahren zu irreführenden oder falschen Tweets hinzufügen können.

Die Grundidee: Wenn Menschen mit unterschiedlichen Weltanschauungen sich auf eine gemeinsame Einordnung verständigen können, ist dies besonders glaubwürdig – und kann in Echtzeit Desinformation entschärfen.

Doch was in der Theorie wie ein demokratisches Korrektiv wirkt, erweist sich in der Praxis zunehmend als strukturell fehlerhaft. Besonders abseits des englischsprachigen Raums versagt das System: Es ist langsam, sprachlich unausgewogen und in Teilen sogar anfällig für gezielte Instrumentalisierung. Eine aktuelle Studie des Center for the Study of Organized Hate (CSOH) unterstreicht: Gerade in Süd- und Südostasien – Regionen mit hoher Anfälligkeit für Online-Desinformation – sind Community Notes nicht nur selten, sondern oft auch wirkungslos.

Ein globales Tool mit einseitigem Fokus

Die Schwächen von Community Notes beginnen bei der globalen Abdeckung. Laut der CSOH-Studiewurden von April 2024 bis April 2025 über 1,85 Millionen öffentliche Notes analysiert. Davon entfielen gerade einmal 1.608 Beiträge auf südasiatische Sprachen wie Hindi, Urdu, Tamil, Bengali oder Nepali – das sind 0,094 Prozent des Gesamtvolumens. Und nur 37 dieser Notizen wurden jemals tatsächlich in der öffentlichen Timeline der Nutzenden angezeigt.

Diese Zahl ist alarmierend, bedenkt man, dass Südasiens Bevölkerung rund ein Viertel der Welt ausmacht und etwa fünf Prozent der monatlichen X-Nutzer:innen stellt. Während englischsprachige Desinformation regelmäßig kontextualisiert wird, bleibt ein Großteil der Falschinformationen in südasiatischen Sprachen unberührt.

Diese Ungleichheit ist nicht nur ein technisches Versäumnis, sondern auch ein Gerechtigkeitsproblem: Die Plattform schafft ein Zwei-Klassen-System, in dem die einen durch kollektive Einordnung geschützt sind, während andere schutzlos der Manipulation ausgeliefert bleiben.

Technische Hürden und algorithmische Blindstellen

Community Notes basiert auf zwei zentralen Mechanismen: Erstens müssen Nutzer Notizen als „hilfreich“ bewerten, und zweitens muss ein sogenannter Bridging Test bestanden werden – dabei müssen Personen mit unterschiedlichen politischen Haltungen zustimmen. In der Theorie soll dies sicherstellen, dass Notes nicht in ideologischen Filterblasen entstehen. In der Praxis aber sorgt genau dieser Konsensmechanismus in sprachlich kleineren Communities für systematische Blockaden.

Südasien ist laut WEF gegenüber Mis-und Desinformation besonders exponiert. Gerade bei vielen südasiatischen Sprachen fehlt es an aktiven Reviewern mit hinreichend unterschiedlichen Perspektiven. So erreichen selbst akkurate, gut bewertete Notes häufig nicht die Veröffentlichungsschwelle. Während etwa 65 Prozent der englischen Notes diesen zweiten Test bestehen, gelingt das in südasiatischen Sprachen nur bei weniger als 40 Prozent. Das Resultat: Desinformation bleibt stehen, während Richtigstellungen in Entwürfen verschwinden.

Hinzu kommt: Anders als bei normalen Tweets gibt es keine inhaltliche Moderation durch X, wenn Community Notes eingereicht werden. Die Plattform verlässt sich vollständig auf die Öffentlichkeit, bzw. ihre Nutzenden. Das ist besonders problematisch, da in bestimmten Sprachkontexten – wie Hindi oder Urdu – beleidigende, hetzerische oder extremistische Narrative im Digitalen zum politischen Alltag gehören. Die CSOH-Studie dokumentiert etwa Notes-Entwürfe mit Formulierungen wie „Italian-mafia supporters“ für Wähler:innen der indischen Kongresspartei oder diffamierende Begriffe für pakistanische Polizeikräfte.

Der westliche Blick: Symbol statt Substanz

Auch im Westen gilt Community Notes oft als Vorzeigebeispiel für transparente, dezentrale Inhaltsmoderation. Elon Musk selbst lobte das Feature mehrfach als „Schutzschild gegen Zensur“ und „beste Verteidigung gegen Desinformation“. Doch diese Selbstdarstellung blendet strukturelle Probleme aus: So zeigt eine unabhängige Momentaufnahme eines US-Pilotprojekts von Meta – das ein ähnliches Feature wie X testet –, dass die Mehrzahl der Einträge entweder irrelevant oder sachlich falsch war.

Auch in westlichen Kontexten bleibt die Frage: Wer verfasst Notes? Wer stimmt darüber ab? Und welche Inhalte erreichen die nötige Schwelle, um veröffentlicht zu werden? Der Anspruch, pluralistische Verständigung zu fördern, läuft ins Leere, wenn das System auf homogenen oder inaktiven Nutzergruppen basiert. Es entsteht kein demokratischer Diskursraum, sondern eine Echokammer algorithmischer Unzulänglichkeit.

Strukturelle Folgen: Sprachliche Ungleichheit als demokratisches Risiko

Die strukturellen Schwächen von Community Notes wirken sich nicht nur auf einzelne Posts aus, sondern gefährden die Integrität von Plattformen in ihrer Gesamtheit. In Wahlkampfphasen – etwa während der indischen Parlamentswahlen 2024 – stieg das Note-Volumen in südasiatischen Sprachen kurzzeitig stark an. Doch genau in diesen entscheidenden Momenten erwies sich das System als nicht skalierbar: Entwürfe stauten sich, während Falschinformationen viral gingen. Das Tool versagte just in dem Moment, in dem es am dringendsten gebraucht wurde.

Die Studie warnt zu Recht: Wenn Plattformen wie X oder künftig Meta ihr Engagement auf Hochphasen beschränken, statt dauerhaft vielfältige Reviewer-Netzwerke aufzubauen, verfehlen sie den eigentlichen Zweck. Auch die Veröffentlichungsschwellen müssen realitätsnah justiert werden – etwa indem kleinere, aber glaubwürdige Reviewer-Gruppen in Sprachen wie Nepali oder Bengali stärker gewichtet werden.

Fazit: Der Schein der Kollektivität

Community Notes verspricht kollektive Aufklärung, schafft aber im aktuellen Zustand nur eine Illusion von Gleichheit. Wer Englisch spricht, ist geschützt; wer Hindi, Urdu oder Tamil nutzt, bleibt verwundbar. In einer Zeit, in der Plattformen immer stärker politische Räume prägen, ist dies nicht nur ein technisches Versäumnis, sondern ein demokratischer Skandal.

Die Zukunft der digitalen Desinformationsbekämpfung liegt nicht in idealisierten Crowdsourcing-Träumen, sondern in konsequentem, gerechtem und sprachlich sensiblem Design. Nur so können Plattformen den Anspruch erfüllen, globale Gemeinschaften zu schützen – und nicht zu spalten.

Worüber wir aktuell beim Rauchen reden:

Hier geben wir jede Ausgabe einen kurzen Einblick in die Themen, die wir in den nächsten Tagen und Wochen beobachten und für spannend und/oder relevant erachten. Diese Themen werden bei uns traditionell bei einer Zigarette und einem Erfrischungsgetränk nach Wahl und Aktualität redaktionell aufgearbeitet und heiß diskutiert.

Frankreichs OSINT-Reserve: Kapazitätsaufbau als Schlüssel zur digitalen Resilienz

Mit dem Aufbau des Bataillon de renseignement de réservistes spécialistes (B2RS) unter dem neuen Kommando CAPR institutionalisiert Frankreich als erstes europäisches Land offene Quellen (OSINT) als festen Bestandteil militärischer Entscheidungsprozesse. Der Ansatz geht weit über symbolische Einbindung hinaus: Das B2RS liefert geprüfte OSINT-Produkte an das Centre du renseignement Terre, wo sie mit klassischen Aufklärungsdaten aus GEOINT, SIGINT und HUMINT kombiniert werden – ein echter All-Source-Intelligence-Ansatz. Zivilgesellschaftliche Expertise aus Digital- und Analyseberufen wird gezielt in modularen Schulungen aufgebaut und operationalisiert. Rekrutiert wird über das Reserveportal des Verteidigungsministeriums, vorrangig in Universitätsstädten mit starkem Digital-, Luft- und Raumfahrtökosystem; bevorzugt werden Studierende und Fachkräfte aus Informatik, Datenanalyse, Geopolitik und Sprachwissenschaften. Die rasche Skalierung – von der Idee bis zur Einsatzfähigkeit innerhalb eines Jahres – zeigt, dass Kapazitätsaufbau nicht nur technische Infrastruktur, sondern auch personelle Innovationsfähigkeit meint. Vor dem Hintergrund wachsender Datenmengen und verkürzter Entscheidungszyklen in modernen Konflikten adressiert Frankreich so eine der zentralen Herausforderungen digitaler Resilienz: die Fähigkeit, relevante Informationen in Echtzeit zu filtern, zu verknüpfen und in operatives Handeln zu übersetzen. OSINT wird damit nicht zur Alternative klassischer Aufklärung, sondern zu deren unverzichtbarem Beschleuniger.

Ein solches Modell könnte auch andernorts als Blaupause dienen – insbesondere für Staaten, die ihre digitale Resilienz stärken und zivile Kompetenzen systematisch in sicherheitsrelevante Strukturen integrieren möchten.